Tijdens het week-end, YouTube activist Matt Watson bereikte de voorpagina van Reddit met een video over een storend fenomeen ontdekte hij op het videohostingplatform van Google, de op één na grootste zoekmachine ter wereld. Watson demonstreerde hoe hij door normale, geschikte YouTube-content heen kon klikken naar suggestieve video's van jonge meisjes. Hoewel veel van deze video's, waarin preteens te zien zijn die bikini's dragen en vampieren in hun slaapkamers, niet expliciet seksueel waren, was het merendeel becommentarieerd door gebruikers met schijnbaar pedofiel intentie. Sommige opmerkingen bevatten tijdstempels voor specifieke momenten waarop de jonge meisjes zich in een compromitterende positie bevonden. Sommige reacties bevatten links naar privé, niet-vermelde video's. Met deze YouTube-clips werden inkomsten gegenereerd via advertenties voor bedrijven als Grammarly en Google zelf.

Kort daarna Watsons video, waaruit bleek dat hij afschuw uitte over het fenomeen, klom op de Reddit-ranglijst,

Dit was iets, maar als Forbes, Mashable, Zakelijke Insider, en The New York Times iedereen wees erop dat het geen oplossing was voor een schijnbaar algoritmisch, menselijk of machinaal leerprobleem.

Interessant is dat veel video's die Watson heeft bekeken, uitgeschakelde opmerkingen hadden, wat suggereert dat YouTube-contentmanagers hebben de reeks opmerkingen opgemerkt en hebben geprobeerd het voor pedofielen moeilijker te maken om hun plaats. Maar al die inspanningen die werden bevestigd, waren een besef van het onopgeloste probleem.

Het is zelfs duidelijk dat het probleem dateert uit ten minste 2017. In dezelfde maand dat de “Elsagaat” De controverse explodeerde, mensen begonnen alarm te slaan over rare, impliciet seksuele opmerkingen op video’s van kleine kinderen, gemaakt voor kinderen. Grote adverteerders houden van AT&T stopte met het uitgeven van advertenties op de site toen de BBC meldde dat ongepaste reacties op video's van kinderen waarmee inkomsten werden gegenereerd, vaak tijdstempels bevatten voor secondenlange momenten van suggestieve posities en links naar niet-vermelde video's - en adverteerders hervatten hun uitgaven niet totdat het probleem 'opgelost' was. Op 21 februari AT&T, dat net in januari weer was begonnen met adverteren op het platform, zei dat ze zouden stoppen met het uitgeven van advertenties op het platform. Hasbro, Nestle en Disney hebben allemaal hetzelfde voorbeeld gevolgd.

Elsagate is niet hetzelfde als een pedofilie-ring, maar de problemen zijn met elkaar verbonden. Contentfarms maakten gebruik van zoekwoorden en plaatsten automatisch advertenties op basis van kanaalbetrokkenheid en slordige AI-filtering, en tekenfilms gemaakt waarin personages zonder vergunning van populaire kinderen werden gebruikt franchises. Veel van deze "inhoud boerderijen" - dat wil zeggen, bedrijven die deze video's hebben gemaakt - hebben hun hoofdkantoor in plaatsen zoals Ho Chi Minh-stad, Vietnam. Ze waren niet educatief of kindvriendelijk, maar verspreidden zich op YouTube-kinderen als video's waarmee inkomsten werden gegenereerd.

YouTube hun richtlijnen voor het genereren van inkomsten gewijzigd na de dubbele schandalen in 2017. Tegenwoordig moeten videomakers minimaal 1.000 abonnees hebben en hun video's 4.000 uur hebben bekeken. Deze regels zijn pas na Elsagate ingevoerd en nu beweert het bedrijf dat alle video's waarmee inkomsten worden gegenereerd, worden beoordeeld door echte mensen, niet AI, om ongepaste advertenties te beteugelen (denk aan: een Google-advertentie die een video prerollt van een tween-meisje dat een lolly eet waarvan meer dan 1 miljoen keer bekeken).

Daarom zo veel video's van kinderen hebben reacties uitgeschakeld onder de video's. De 10.000 menselijke recensenten van YouTube, die belast zijn met het beoordelen van de 400 uur aan beeldmateriaal dat elke minuut naar YouTube wordt geüpload, zijn ook verantwoordelijk voor het kijken over de betrokkenheid bij genoemde video's en het uitschakelen van ongepaste opmerkingen, links naar niet-vermelde video's of tijdstempels van de kinderen in suggestieve posities.

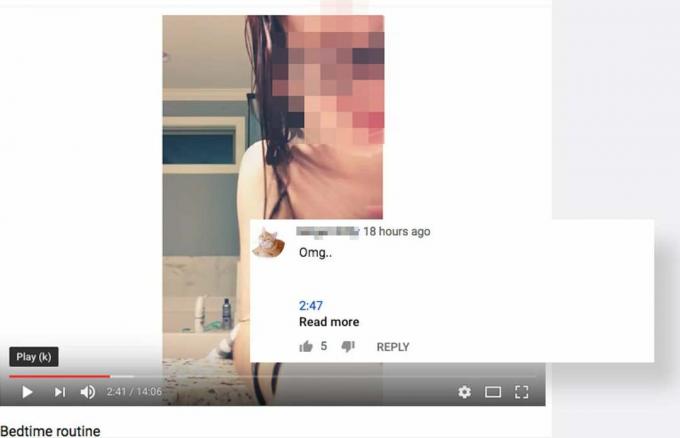

Ik heb een nieuw YouTube-account gemaakt nadat ik ontdekte dat mijn algoritmen zo diepgeworteld waren dat het moeilijk was om ongepaste inhoud te vinden, en ik zocht hetzelfde wat Watson zocht - 'bikini-trek'. Binnen 12 klikken zat ik in een raar konijnenhol vol kinderworstelvideo's en meisjesnachten routines. Ik kwam een video van 30+ minuten tegen en vond dit:

Om 21:25 bewoog het meisje in de video zich weg van de camera en heel even was haar kruis in zicht.

Ik kwam ook een hele reeks modellenvideo's tegen van jonge meisjes die duidelijk onder de 18 waren. Commentatoren merkten op hoe mooi de modellen waren en hoe geweldig ze eruit zagen in hun ondergoed, ondanks het feit dat het kinderen zijn. Ik zal de video's niet delen omdat ze ongepast zijn; maar het feit is dat deze opmerkingen niet alleen uitgebreid moeten worden gecontroleerd, ze zouden misschien helemaal niet op de website moeten staan. Er is geen actie ondernomen tegen die opmerkingen of de video zelf van minderjarigen die ondergoed modelleren.

En een ander meisje plaatste een video van haar nachtelijke routine, na het douchen. Het meisje, wiens YouTube-pagina heet "Makenzie's Fortnite-ervaring” en die niet ouder lijkt te zijn dan 13 jaar, beweegt per ongeluk haar handdoek op een manier in de video die de zijkant van haar naakte torso laat zien na 2:47 minuten.

Deze video had natuurlijk nooit geüpload mogen worden. Het meisje erin is duidelijk pre-puberaal en draagt een handdoek om haar nachtelijke routine uit te leggen. Deze video heeft zo'n 51.000 views. De rest van haar video's hebben tussen de acht en 150 views. Dus, waarom gebeurt dit? Weet ze waarom 51.000 mensen deze video hebben bekeken en geen van haar Fortnite-video's of leuke knutselvideo's? Begrijpt ze dat er mensen zijn die hier niet naar kijken omdat ze niet echt om haar nachtelijke routine geven, maar een klein meisje in een handdoek willen zien? Kan zijn. Misschien niet. Ze is een kind. Iemand zou haar internetgebruik beter in de gaten moeten houden, maar dat is ook moeilijk. En dat is waar YouTube zou binnen moeten komen, maar niet. Dit is ongepaste inhoud, zelfs als deze niet openlijk seksueel is vanwege de manier waarop deze waarschijnlijk wordt geconsumeerd. Dit zijn geen opwindende dingen, tenzij je het soort persoon bent dat het specifiek opwindend vindt.

Hoewel er geen inkomsten werden gegenereerd met deze video's voor advertenties, werden ze ook duidelijk niet gecontroleerd door mensen of AI - althans niet effectief. Sommige video's zouden helemaal niet op YouTube moeten staan, maar miljoenen views hebben. Als commentaar en contentmoderatie zo ondoeltreffend zijn als het lijkt, zullen kinderen het onderwerp blijven van seksuele interesse op het platform, dat een hulpmiddel zal blijven voor roofdieren.

Nu YouTube een plek wordt waar steeds meer kinderen video's consumeren en ook een plek wordt waar ze hun creaties laten zien, zijn degenen die verantwoordelijk zijn voor de platform een beslissing moeten nemen over de vraag of matiging moet worden nagestreefd in het belang van plausibele ontkenning of in het belang van bescherming kinderen. Als het bedrijf tot de laatste conclusie komt - en laten we hopen van wel - zullen ze zowel hun personeel als hun software moeten heroverwegen. Doen ze dat niet, dan moeten ze heroverwegen welke rol ze op internet willen spelen.